Leggi tutto

Crawl Budget: cos’è e perchè dovresti ottimizzarlo

"Il Crawl Budget rappresenta un elemento cruciale nella SEO tecnica. Questo parametro indica il tempo che Google dedica alla scansione di un sito web. Per i proprietari di siti di grandi dimensioni, l’ottimizzazione del crawl budget diventa fondamentale per migliorare la visibilità online. La gestione del budget di scansione influenza direttamente l’efficienza con cui Googlebot […]

Il Crawl Budget rappresenta un elemento cruciale nella SEO tecnica. Questo parametro indica il tempo che Google dedica alla scansione di un sito web. Per i proprietari di siti di grandi dimensioni, l’ottimizzazione del crawl budget diventa fondamentale per migliorare la visibilità online.

La gestione del budget di scansione influenza direttamente l’efficienza con cui Googlebot esplora le pagine di un sito. Un’attenta ottimizzazione può garantire che le pagine più importanti vengano scansionate e indicizzate più frequentemente, migliorando così le prestazioni SEO complessive del sito.

Definizione e importanza del Crawl Budget

Il crawl budget o budget di scansione è un concetto chiave per l’ottimizzazione dei siti web. Esso determina quante pagine Googlebot può esplorare su un sito in un dato periodo.

Cosa si intende per Crawl Budget

Il Crawl Budget rappresenta il limite di risorse che Google assegna alla scansione di un sito. Esso influenza direttamente la frequenza e la profondità con cui i motori di ricerca esplorano le pagine web.

Perché è fondamentale per la SEO

Un budget di scansione ottimizzato è cruciale per la SEO. Permette una più rapida indicizzazione dei nuovi contenuti, migliorando la visibilità del sito nelle pagine dei risultati di ricerca. Questo si traduce in un vantaggio competitivo significativo.

Come influisce sull’indicizzazione e posizionamento del sito

La scansione Googlebot impatta direttamente sull’indicizzazione del sito web. Un Crawl Budget efficiente consente ai motori di ricerca di trovare, scansionare e classificare le pagine in modo più efficace, influenzando positivamente le prestazioni SEO complessive.

| Aspetto | Impatto del Crawl Budget |

|---|---|

| Velocità di indicizzazione | Aumenta significativamente |

| Posizionamento nei risultati di ricerca | Migliora notevolmente |

| Efficienza della scansione | Ottimizza l’uso delle risorse |

Come viene calcolato il Crawl Budget da Google

Il calcolo del crawl budget è un processo complesso che l’algoritmo Google esegue per ottimizzare le sue risorse di scansione. Google utilizza due fattori principali per determinare il crawl budget di un sito web: il Crawl Rate Limit e la Crawl Demand.

Il Crawl Rate Limit rappresenta il numero massimo di connessioni simultanee che Googlebot può utilizzare per scansionare un sito senza sovraccaricarlo. Questo limite viene stabilito in base alle prestazioni del server e alla capacità di risposta del sito.

La Crawl Demand, invece, è legata alla popolarità e alla frequenza di aggiornamento delle pagine. Siti web con contenuti freschi e di alta qualità tendono ad avere una maggiore domanda di scansione da parte di Google.

Oltre a questi due fattori principali, l’algoritmo Google considera anche altri parametri di scansione importanti:

- La salute complessiva del sito web

- I limiti impostati manualmente in Google Search Console

- L’importanza percepita del sito nell’ecosistema web

Tutti questi elementi contribuiscono a determinare la frequenza e la profondità con cui Google scansiona un sito web, influenzando direttamente il suo posizionamento nei risultati di ricerca.

Fasi del Crawl Budget

Ecco lo schema visivo del processo del Crawl Budget di Google in italiano con una struttura più chiara:

- Inizio Googlebot: Googlebot inizia il processo di scansione.

- Verifica limite velocità di scansione: Googlebot verifica il limite di velocità di scansione per evitare di sovraccaricare il server.

- Valutazione domanda di scansione: Googlebot valuta la necessità di scansione basata sulla popolarità del sito, la frequenza di aggiornamento dei contenuti e la struttura del sito.

- Recupera e analizza pagine: Googlebot recupera e analizza le pagine del sito.

- Allocazione risorse: Googlebot assegna le risorse di scansione in base al Crawl Budget.

- Indicizzazione: le pagine scansionate vengono indicizzate se ritenute pertinenti e di qualità.

- Ciclo di feedback: Googlebot aggiorna il Crawl Budget basato sulle prestazioni e sul comportamento del sito.

Fattori che influenzano il Crawl Budget

Il Crawl Budget è influenzato da diversi fattori chiave che determinano come Google scansiona e indicizza un sito web. Comprendere questi elementi è fondamentale per ottimizzare la presenza online.

Popolarità del sito

Siti più popolari tendono ad avere un Crawl Budget maggiore perché hanno un traffico maggiore e sono considerati più rilevanti.

Frequenza di aggiornamento del contenuto

Siti che aggiornano frequentemente i loro contenuti hanno bisogno di essere scansionati più spesso per mantenere aggiornato l’indice di Google.

Dimensione del sito

Siti con molte pagine necessitano di un Crawl Budget maggiore per poter scansionare tutte le pagine in modo efficiente.

Qualità del contenuto

Contenuti di alta qualità e rilevanti possono aumentare il Crawl Budget, poiché Google vuole indicizzare contenuti utili per gli utenti.

Link Interni ed esterni

Un buon sistema di collegamenti interni facilita la navigazione di Googlebot attraverso il sito.

Link da siti esterni (backlink) autorevoli possono aumentare l’importanza del sito agli occhi di Google.

Architettura del sito

Una struttura del sito ben organizzata e pulita può facilitare la scansione e l’indicizzazione delle pagine.

Utilizzo del file robots.txt

Configurazioni errate nel file robots.txt possono impedire a Googlebot di accedere a certe pagine, riducendo così il Crawl Budget effettivo utilizzato.

Pagine duplicate

La presenza di molte pagine duplicate può influenzare negativamente il Crawl Budget, in quanto Googlebot spreca risorse scansionando contenuti ridondanti.

Errori 404 e altri errori HTTP

Un alto numero di errori 404 (pagina non trovata) e altri errori HTTP può influenzare negativamente il Crawl Budget, poiché Googlebot spreca risorse su pagine non valide.

Crawl Rate Limit: capacità di gestione delle scansioni

Il limite di scansione rappresenta la capacità del server di gestire le richieste di Googlebot senza compromettere le prestazioni del sito. Un server robusto può sostenere più scansioni, aumentando potenzialmente il Crawl Budget assegnato.

Crawl Demand: frequenza di aggiornamento e popolarità

La domanda di crawling è influenzata dalla popolarità delle pagine e dalla frequenza con cui vengono aggiornate. Siti con contenuti freschi e rilevanti tendono a ricevere più attenzioni da parte dei motori di ricerca, incrementando così il loro Crawl Budget.

Prestazioni del server e velocità del sito

La velocità del sito gioca un ruolo cruciale nel determinare il Crawl Budget. Un sito rapido e reattivo può gestire più scansioni in meno tempo, permettendo a Google di esplorare più pagine.

Se il server del sito risponde lentamente o ha problemi di downtime frequenti, Googlebot potrebbe ridurre la velocità di scansione per evitare di sovraccaricare il server.

| Fattore | Impatto sul Crawl Budget |

|---|---|

| Limite di scansione | Determina la quantità di richieste gestibili |

| Domanda di crawling | Influenza la frequenza delle scansioni |

| Velocità del sito | Aumenta l’efficienza delle scansioni |

Altri fattori rilevanti includono la struttura del sito, la presenza di errori, i contenuti duplicati e la qualità complessiva delle pagine. Ottimizzare questi elementi può migliorare significativamente l’allocazione del Crawl Budget da parte di Google.

Strategie per ottimizzare il Crawl Budget

L’ottimizzazione del crawl budget è fondamentale per migliorare la visibilità del tuo sito web. Ecco alcune tecniche SEO efficaci per il miglioramento della scansione:

Elimina i contenuti duplicati dal tuo sito. Questi possono confondere i crawler e sprecare preziose risorse di scansione. Identifica e rimuovi le pagine con contenuti simili o identici.

Correggi i link rotti e riduci i redirect non necessari. I link rotti frustrano sia gli utenti che i crawler, mentre troppi redirect rallentano la scansione. Usa strumenti di analisi per individuare e risolvere questi problemi.

Ottimizza la tua sitemap XML. Una sitemap ben strutturata aiuta Googlebot a navigare efficacemente il tuo sito. Assicurati che includa solo le pagine importanti e che sia aggiornata regolarmente.

- Migliora i tempi di caricamento delle pagine

- Implementa una corretta struttura dei link interni

- Riduci il numero di pagine non indicizzabili

Pubblica contenuti di alta qualità e aggiorna regolarmente il tuo sito. Questo non solo attrae più visite, ma segnala anche a Google che il tuo sito merita scansioni frequenti.

Usa saggiamente il file robots.txt e le direttive meta robots. Questi strumenti ti permettono di guidare l’attenzione di Googlebot sulle pagine più importanti, ottimizzando l’uso del tuo crawl budget.

Monitoraggio e analisi del Crawl Budget

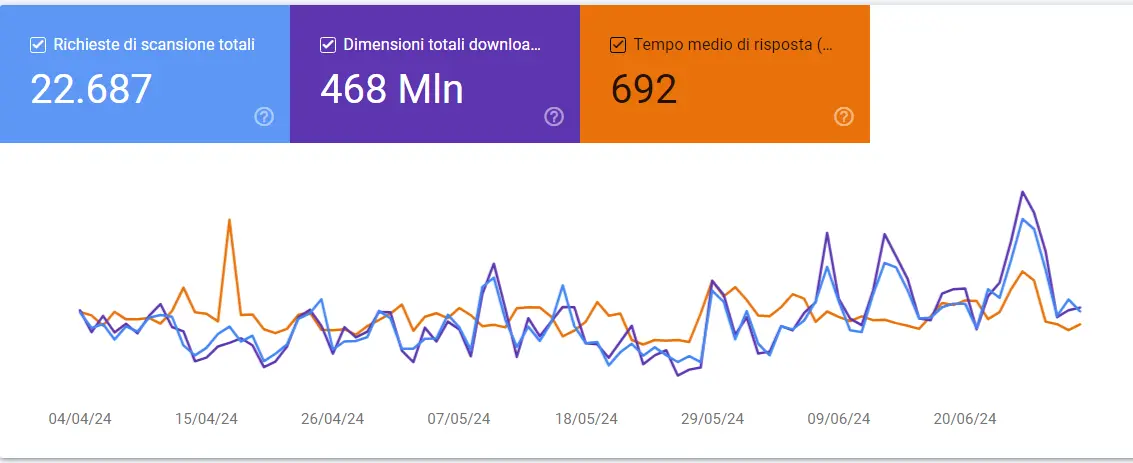

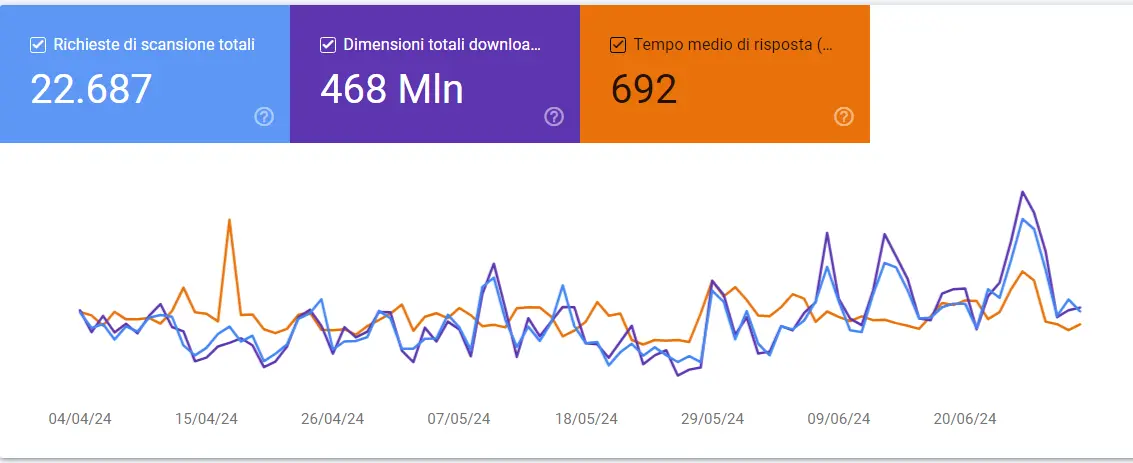

Il monitoraggio del crawl budget è essenziale per ottimizzare le prestazioni SEO del sito web. Google Search Console offre uno strumento prezioso per questo scopo, permettendo di visualizzare le statistiche di scansione. Queste includono il numero di richieste, le dimensioni dei download e i tempi di risposta medi.

Come leggere questo grafico

Nel grafico delle statistiche di scansione di Google Search Console (GSC), è importante monitorare alcuni parametri chiave per valutare l’efficacia del crawl budget del tuo sito. Un parametro soddisfacente è una tendenza stabile o in aumento nel numero di pagine scansionate giornalmente, che indica che Googlebot sta esplorando il tuo sito con regolarità e completezza. Un altro aspetto cruciale è il tempo di download della pagina: valori inferiori ai 200 millisecondi suggeriscono che il server risponde rapidamente, migliorando l’esperienza di scansione. Fino a 500 millisecondi, comunque, ci si può ritenere soddisfatti.

Infine, tieni d’occhio eventuali picchi o cali significativi, che potrebbero segnalare problemi tecnici o modifiche nel contenuto del sito. Un grafico che mostra una scansione costante e un tempo di risposta rapido può essere considerato un buon segnale di salute del tuo crawl budget.

Come approfondire l’analisi

Per un’analisi più approfondita, è utile esaminare i log del server. Questi forniscono dettagli sulla frequenza e la profondità delle scansioni di Googlebot, offrendo una visione più completa del comportamento del crawler. L’uso di strumenti SEO avanzati può arricchire ulteriormente questa analisi.

Un monitoraggio regolare del crawl budget permette di identificare rapidamente eventuali problemi e opportunità di miglioramento. Questa pratica aiuta a garantire che le pagine più importanti del sito vengano scansionate e indicizzate efficacemente, massimizzando la visibilità nei risultati di ricerca.